Trong hồi quy logistic, ta cần tìm vector tham số ![]() (và bias

(và bias ![]() ) sao cho mô hình dự đoán xác suất

) sao cho mô hình dự đoán xác suất ![]() khớp tốt nhất với dữ liệu quan sát.

khớp tốt nhất với dữ liệu quan sát.

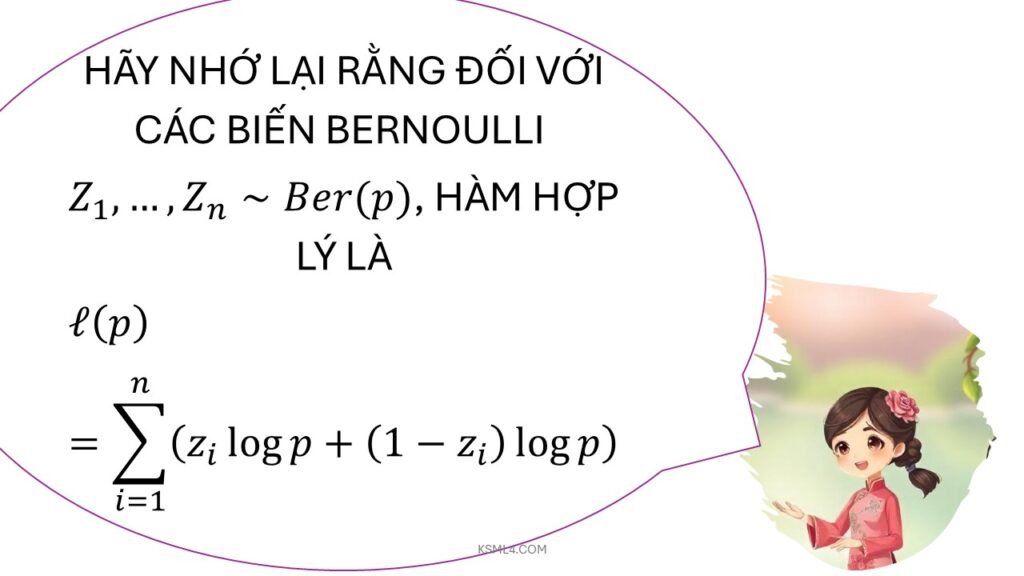

🔎 1. Hàm xác suất (Likelihood)

Với dữ liệu ![]() , trong đó

, trong đó ![]() :

:

![]()

Trong đó:

![]()

Hàm likelihood cho toàn bộ dữ liệu:

![]()

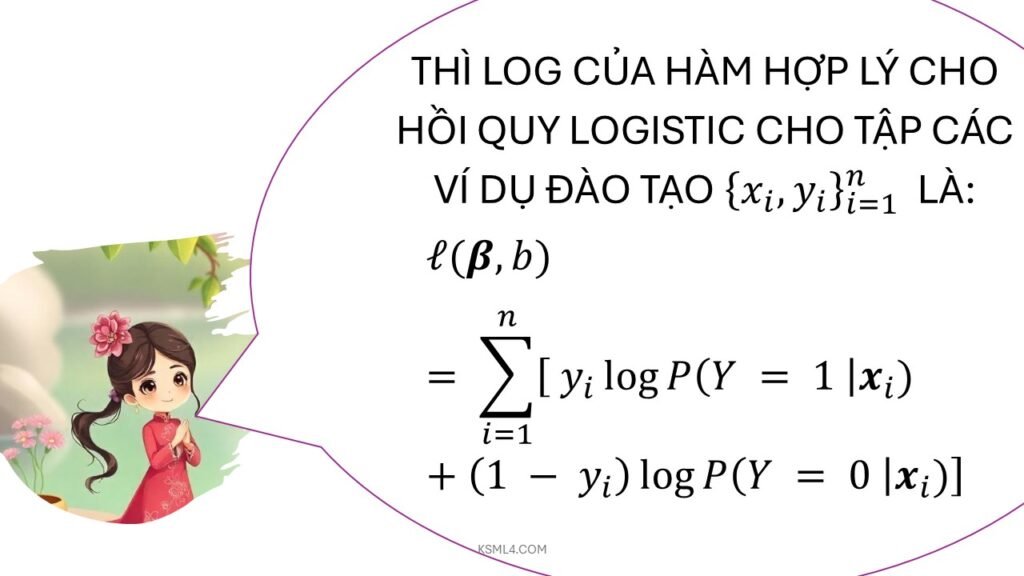

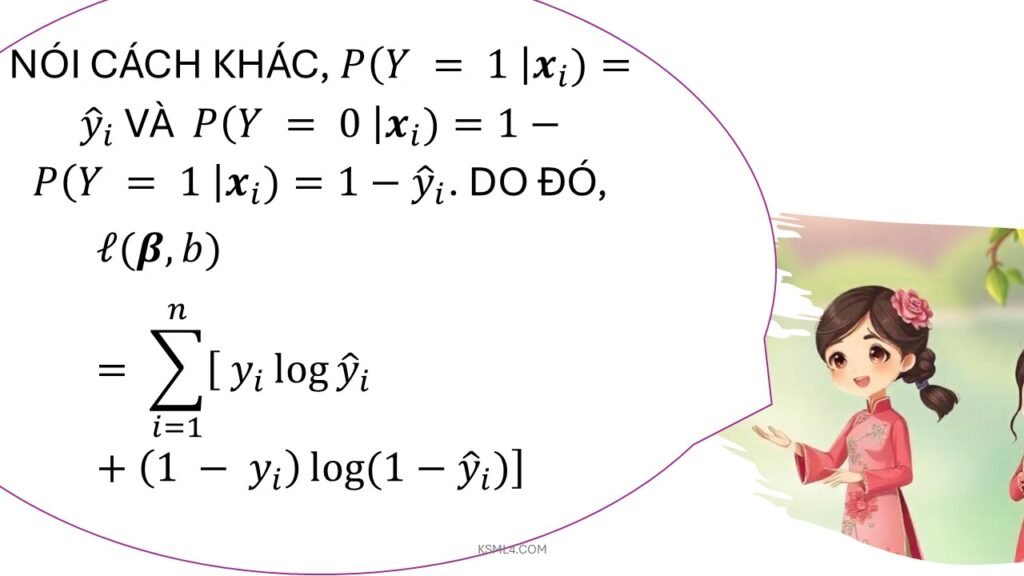

🔎 2. Hàm log-likelihood

Để dễ tính toán, lấy log:

![]()

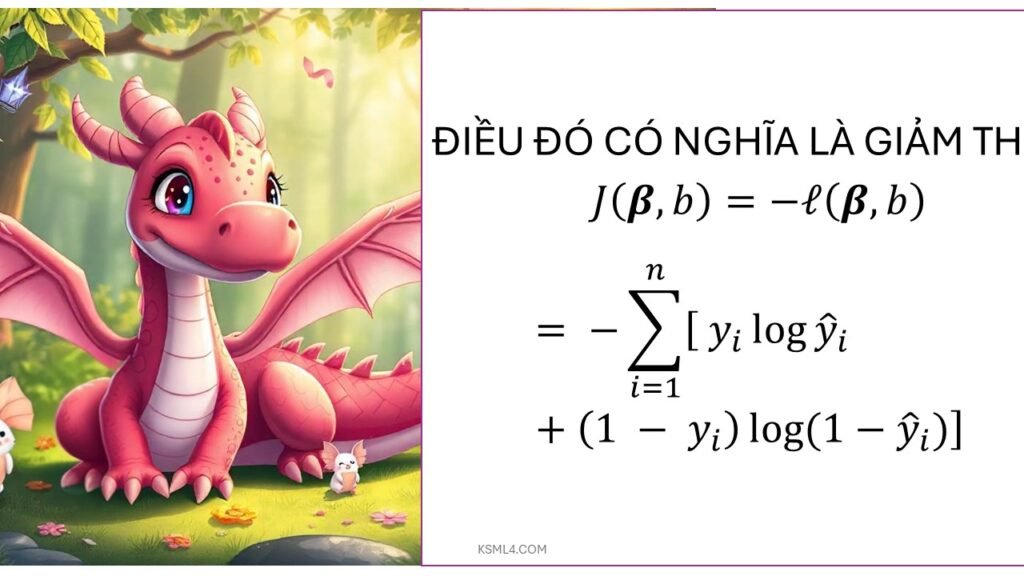

🔎 3. Hàm mất mát (Loss function)

Trong học máy, ta thường dùng negative log-likelihood (hay cross-entropy loss):

![Rendered by QuickLaTeX.com \[ J(w) = -\ell(w) = - \sum_{i=1}^n \Big[ y_i \log p(x_i) + (1-y_i)\log(1-p(x_i)) \Big]\]](https://vi.ksml4.com/wp-content/ql-cache/quicklatex.com-256b23ffa39f1404b2b88e615ca80343_l3.png)

Mục tiêu: tối thiểu hóa ![]() .

.

🔎 4. Ước lượng tham số

- Không có công thức đóng (closed-form) như hồi quy tuyến tính.

- Thường dùng phương pháp tối ưu số:

Gradient Descent: cập nhật tham số theo đạo hàm của hàm mất mát.

Stochastic Gradient Descent (SGD): cập nhật theo từng mẫu hoặc mini-batch.

Newton-Raphson / Iteratively Reweighted Least Squares (IRLS): dùng ma trận Hessian để hội tụ nhanh hơn.

Gradient của hàm mất mát:

![]()

Cập nhật tham số:

![]()

Trong đó ![]() là learning rate.

là learning rate.

🌍 Ý nghĩa

- Hồi quy logistic thực chất là ước lượng tham số bằng Maximum Likelihood Estimation (MLE).

- Các thuật toán tối ưu như Gradient Descent giúp tìm bộ tham số

tốt nhất để mô hình dự đoán xác suất chính xác.

tốt nhất để mô hình dự đoán xác suất chính xác.